Sztuczna inteligencja na usługach służb. Niezgodnie z prawem i zdrowym rozsądkiem

Kwestie przewidywania przyszłości nurtowały ludzkość już od tysiącleci. Najpierw zajmowali się tym wszelkiej maści magowie, z czasem oddając rozważania nad przyszłością duchownym oraz filozofom. W XX wieku spojrzenie na przyszłość rozdzieliło się na dwa naukowe nurty. Z jednej strony Niels Bohr, duński fizyk i laureat Nagrody Nobla za stworzenie modelu atomu, mawiał, że „generalnie przewidywanie jest bardzo trudne, szczególnie, jeśli idzie o przyszłość”. Z drugiej Peter Drucker, ekonomista i teoretyk zarządzania, przekonywał, że „najlepszą metodą przewidywania przyszłości jest jej tworzenie”. Kwestie zerkania w to, co stanie się za tydzień, miesiąc czy rok, stały się domeną pisarzy science fiction, z których jeden – Philip Dick – w swoim „Raporcie mniejszości” opisał dystopijny świat, w którym policja była w stanie przewidzieć przestępstwo, a więc również zapobiec mu, aresztując i skazując na więzienie niedoszłego przestępcę, nawet jeżeli ów przestępca nie miał świadomego zamiaru popełnienia zbrodni. Wymyślone przez Dicka rozwiązanie nie miałoby szansy na zastosowanie w zachodnich służbach publicznych ze względu na obowiązujący w kulturze basenu Morza Śródziemnego model prawny, w którym zamiar popełnienia przestępstwa nie jest i nie może być karalny. Sądy karne nie mogą skazywać za zamiar – istnienie zamiaru może jedynie decydować o uznaniu przestępstwa za umyślne lub nieumyślne, co może mieć wpływ na wysokość kary za popełnione przestępstwo.

CIA patrzy w przyszłość

Jednak okazuje się, że służby i policje od dawna korzystały z pomocy sztucznej inteligencji w przewidywaniu, kto i jaką zbrodnię może popełnić. Specjalny program napisany przez zawodowców ze wspieranej przez CIA amerykańskiej firmy technologicznej Palantir Technologies w czasie rzeczywistym łączy ze sobą wszystkie informacje znajdujące się w policyjnych i publicznych bazach danych, ustalając relacje między ludźmi, grupami, rzeczami i miejscami, wskazując możliwe miejsce popełnienia przestępstwa oraz samego przestępcę. Po pierwszych amerykańskich testach oprogramowanie kupili od Amerykanów Niemcy, uruchamiając je w Republice Federalnej pod nazwą „Hessendata”, co – jak się okazało – doprowadziło do wielu aresztowań, wątpliwych z punktu widzenia niemieckiej konstytucji, bo nie poprzedzonych żadnym przestępstwem. Przykład? Do więzienia trafił podejrzany o próbę kradzieży pieniędzy z bankomatu człowiek, ponieważ współpracująca z niemiecką policją sztuczna inteligencja uznała, że jego samochód znajdował się w pobliżu kilku miejsc zbrodni. Sądy federalne miały dość duży problem z zamykaniem za kratami osób mających wyłącznie status podejrzanych – wszak żaden z nich nie popełnił jeszcze przestępstwa, jednak sprawa przycichła po tym, jak to samo oprogramowanie bezbłędnie wskazało członków organizacji Obywatele Rzeszy, którzy chcieli – zbrojnie, a jakże – doprowadzić w grudniu ub.r. do upadku rządu i przejąć władzę w Republice Federalnej. Niemiecka policja i służby antyterrorystyczne wykorzystały „Hessendata” do wykrycia całej siatki skrajnie prawicowej organizacji przygotowującej się do zamachu stanu. Wszyscy biorący udział w przygotowaniach zostali zatrzymani i czekają na rozpoczęcie procesu.

Niemcy robią krok do tyłu

W imieniu innych zamykanych nieprzestępców wystąpiły do Sądu Najwyższego organizacje broniące praw człowieka, w tym jedna z najważniejszych – Niemieckie Towarzystwo Praw Obywatelskich. Grupa argumentowała to tym, że oprogramowanie wykorzystywało dane niewinnych osób do dostarczania wskazówek, a także mogło powodować błędy i wpływać na osoby zagrożone dyskryminacją policyjną.

Niemiecki Federalny Trybunał Konstytucyjny uznał przepisy, które umożliwiają policji automatyczne przetwarzanie danych osobowych za pomocą specjalnego oprogramowania w celu zapobiegania przestępczości, za niekonstytucyjne. I nie ma już odwołania od tego wyroku.

„Biorąc pod uwagę szczególnie szerokie sformułowanie uprawnień, zarówno pod względem danych, jak i metod, podstawy ingerencji są dalekie od wymaganego konstytucyjnie progu możliwego do zidentyfikowania zagrożenia” – stwierdzili sędziowie.

Przepisy regulujące korzystanie z technologii w centralnym kraju związkowym Hesji i północnym mieście-państwie Hamburgu naruszyły prawo do samostanowienia informacyjnego, stwierdził Trybunał Konstytucyjny.

Sąd orzekł, że automatyczna analiza lub interpretacja danych może być uzasadniona, ale należy wziąć pod uwagę powagę ewentualnych przestępstw.

„Szczególne znaczenie ma zgodność z zasadą proporcjonalności, której szczegółowe wymagania zależą od zakresu uprawnień, o których mowa” – napisano.

Sąd stwierdził, że oba stany z powodzeniem wykazały potrzebę tej technologii, biorąc pod uwagę „rosnące wykorzystanie mediów cyfrowych i środków komunikacji”.

„Szczególnie w obszarach przemocy terrorystycznej i ekstremistycznej oraz przestępczości zorganizowanej i poważnej organy policyjne mają do czynienia z coraz większymi strumieniami danych, które są coraz bardziej heterogeniczne pod względem jakości i formatu”.

Zagrożenie dla ludzkości

Pozostaje pytanie, kto jeszcze kupił od CIA oprogramowanie wyszukujące przyszłych przestępców. I ile osób za wciąż nieistniejący zamiar popełnienia przestępstwa ma kłopoty w samych Stanach Zjednoczonych.

Zaawansowane prace nad podobnym rozwiązaniem trwają również w Chinach, które swoje oprogramowanie chcą sprzedawać na południu Europy i w Afryce. Chiński program może być dużo bardziej niebezpieczny, bo rząd w Pekinie już kilka lat temu wprowadził pełną inwigilację wszystkich obywateli pozwalającą nawet na podsłuchiwanie ich rozmów na ulicy czy w środkach publicznego transportu. Prace nad sztuczną inteligencją kontrolującą społeczeństwo trwają również w Rosji.

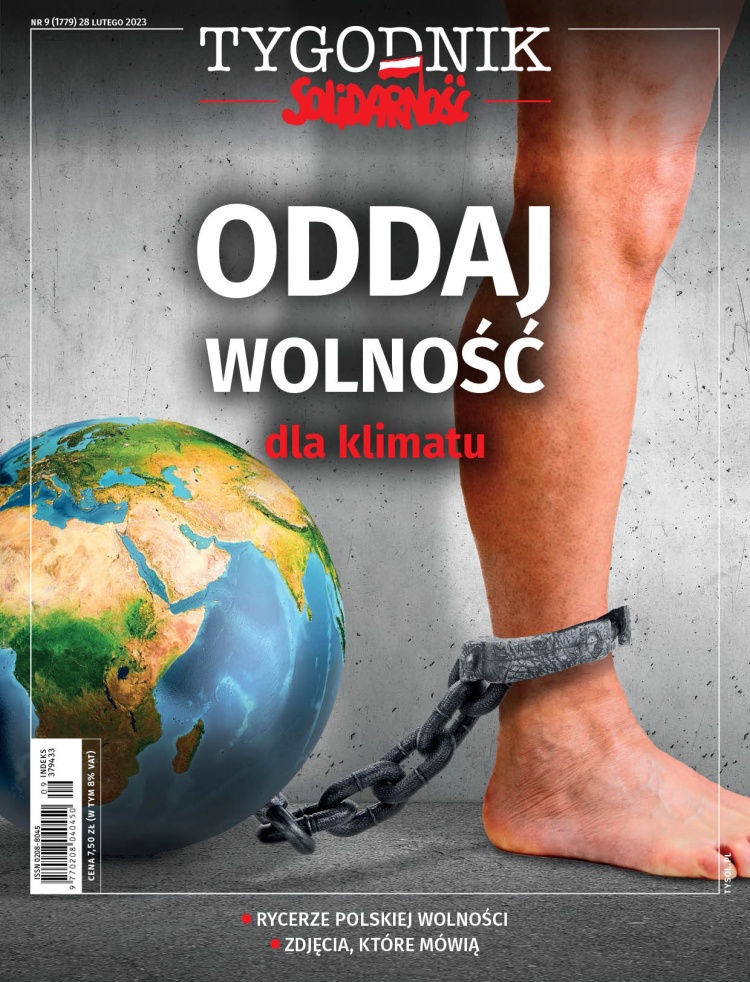

Tekst pochodzi z 9 (1779) numeru „Tygodnika Solidarność”.